psblearn est une bibliothèque Python inspirée de scikit-learn, orientée vers l’apprentissage automatique pratique et la mise en production de modèles. Vous vous demandez comment l’installer, l’utiliser efficacement et l’intégrer à vos pipelines de data science existants ? Ce guide structuré vous donne rapidement les clés essentielles, puis approfondit les points techniques pour vous permettre d’exploiter psblearn de manière fiable et professionnelle.

Bien démarrer avec psblearn et poser des bases solides

Avant de construire des modèles complexes, il est crucial de comprendre ce que propose réellement psblearn et dans quels cas l’utiliser. Dans cette première partie, vous verrez comment l’installer, comment il se positionne par rapport à scikit-learn et quels sont ses principaux atouts. Vous aurez ainsi une vision claire pour décider s’il répond à vos besoins en machine learning.

Comprendre l’ADN de psblearn et son lien avec scikit-learn

psblearn reprend l’architecture éprouvée de scikit-learn tout en ajoutant des fonctionnalités spécifiques pour simplifier la mise en production. Vous retrouvez les mêmes conventions d’API avec les méthodes fit() pour entraîner un modèle et predict() pour générer des prédictions. Cette continuité permet aux data scientists déjà familiers avec l’écosystème Python de basculer rapidement vers psblearn sans réapprendre une nouvelle logique.

La bibliothèque couvre les tâches courantes d’apprentissage supervisé : classification binaire et multiclasse, régression linéaire et non-linéaire, ainsi que des outils d’évaluation et de prétraitement. Comme scikit-learn, psblearn intègre le concept de pipelines qui enchaînent transformations et modélisation dans un workflow cohérent. Cette approche réduit les risques d’erreurs lors du passage des données de développement à la production.

L’avantage principal réside dans cette familiarité. Si vous maîtrisez déjà scikit-learn, vous pourrez importer un classificateur, appliquer une validation croisée ou sauvegarder un modèle en quelques lignes, sans consulter longuement la documentation.

Installer psblearn pas à pas et vérifier votre environnement Python

L’installation de psblearn s’effectue simplement via pip, le gestionnaire de paquets Python standard. Ouvrez votre terminal et exécutez la commande suivante :

pip install psblearn

Pour une gestion plus fine des dépendances, vous pouvez utiliser conda si vous travaillez dans un environnement Anaconda. Les dépendances principales incluent Python 3.7 ou supérieur, numpy pour le calcul matriciel, pandas pour la manipulation de données tabulaires, et scikit-learn comme base algorithmique.

Une fois l’installation terminée, créez un script de vérification minimal :

| Étape | Commande Python |

|---|---|

| Import de la bibliothèque | import psblearn |

| Vérification de version | print(psblearn.__version__) |

| Import d’un module type | from psblearn.model_selection import train_test_split |

Utilisez toujours un environnement virtuel pour isoler vos projets. Créez-le avec python -m venv mon_env puis activez-le avant d’installer psblearn. Cette pratique évite les conflits entre versions de bibliothèques sur votre machine et facilite le déploiement ultérieur.

Dans quels projets psblearn est-il réellement pertinent à utiliser ?

psblearn trouve son utilité dans plusieurs contextes précis. Il excelle pour le prototypage rapide lorsque vous souhaitez tester une hypothèse métier avec des données structurées. Un analyste peut entraîner plusieurs modèles en quelques minutes pour identifier la meilleure approche avant d’investir dans une solution plus lourde.

La bibliothèque convient également à l’enseignement et à la formation, car son API intuitive permet aux débutants de comprendre les concepts fondamentaux sans se perdre dans des détails techniques complexes. Les étudiants peuvent se concentrer sur la logique de validation croisée ou la sélection de features plutôt que sur la syntaxe.

Pour l’industrialisation légère, psblearn offre des outils de sérialisation et d’intégration dans des pipelines automatisés. Une PME peut ainsi déployer un modèle de scoring client ou de prévision de stocks sans infrastructure massive.

En revanche, si vos données dépassent plusieurs dizaines de gigaoctets ou si vous ciblez du deep learning avec réseaux de neurones convolutifs, d’autres solutions comme TensorFlow, PyTorch ou des frameworks big data seront plus appropriées. psblearn reste performant sur des jeux de données de taille moyenne, typiquement quelques millions de lignes sur un serveur standard.

Construire vos premiers modèles machine learning avec psblearn

Une fois la bibliothèque installée, l’essentiel est de réussir à entraîner, évaluer et améliorer un premier modèle sans perdre de temps. Cette section vous guide à travers un flux de travail complet, de la préparation des données jusqu’à l’évaluation. Vous verrez comment psblearn s’intègre naturellement à un workflow data science moderne.

Comment préparer et transformer vos données efficacement avec psblearn ?

La préparation des données représente 70% du temps dans un projet de machine learning. psblearn s’appuie directement sur pandas pour charger vos fichiers CSV, Excel ou bases de données. Une fois les données importées dans un DataFrame, vous pouvez utiliser les transformers compatibles avec l’API scikit-learn pour standardiser votre pipeline.

Commencez par traiter les valeurs manquantes. Vous pouvez remplir les cellules vides avec la médiane pour les variables numériques, ou avec la modalité la plus fréquente pour les variables catégorielles. psblearn propose des imputers simples qui s’intègrent dans un pipeline pour garantir que la même stratégie soit appliquée en entraînement et en production.

Pour les variables catégorielles comme le pays d’origine ou le type de produit, utilisez l’encodage one-hot qui transforme chaque modalité en colonne binaire. La normalisation des variables numériques par StandardScaler ou MinMaxScaler assure que toutes les features contribuent équitablement au modèle, sans qu’une variable d’échelle différente ne domine.

Assemblez ces transformations dans un pipeline unique. Cette architecture évite les fuites de données : les statistiques de normalisation calculées sur l’ensemble d’entraînement ne contaminent pas le jeu de test, préservant ainsi une évaluation honnête de la performance du modèle.

Entraîner un premier modèle de classification supervisée avec psblearn

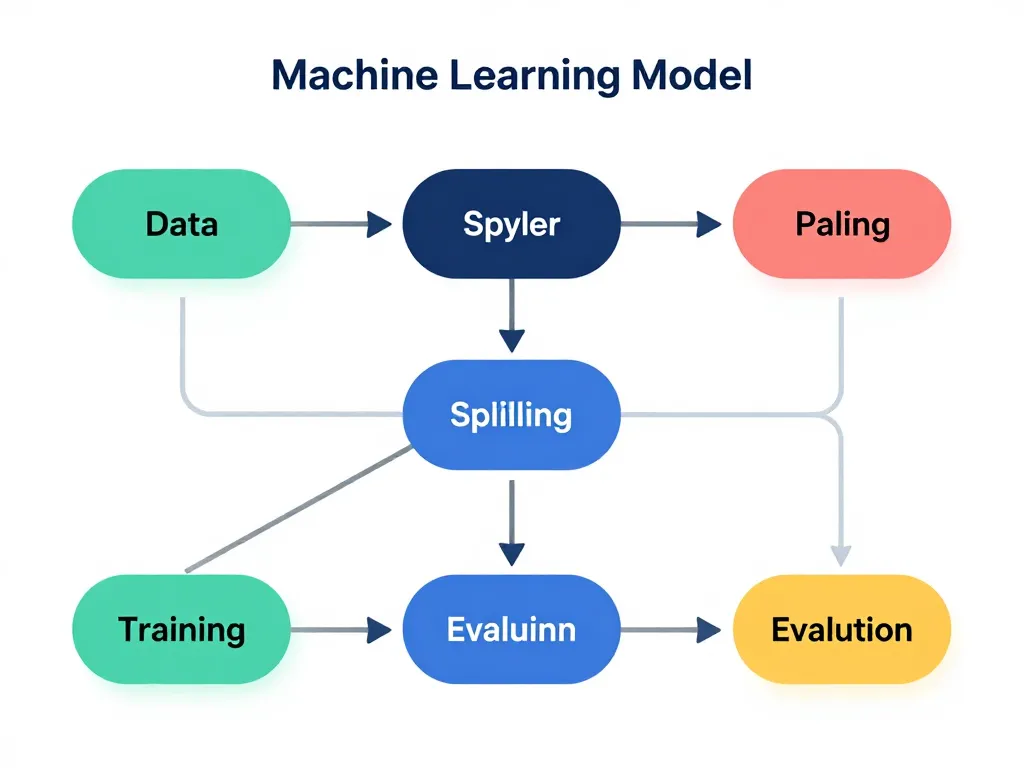

Prenons un exemple concret de classification binaire : prédire si un client va souscrire un produit bancaire. Après avoir chargé vos données avec pandas, séparez les features (X) de la variable cible (y). Utilisez la fonction train_test_split pour diviser votre dataset en 80% d’entraînement et 20% de test.

Instanciez un classificateur simple, par exemple une régression logistique. Appelez la méthode fit(X_train, y_train) pour entraîner le modèle. L’algorithme ajuste ses paramètres internes pour minimiser l’erreur sur les données d’entraînement. Ensuite, générez les prédictions avec predict(X_test) sur le jeu de test.

Pour garantir la reproductibilité, fixez la graine aléatoire au moment de la séparation train/test et lors de l’initialisation du modèle. Ajoutez un paramètre random_state=42 pour que vos collègues obtiennent exactement les mêmes résultats en relançant votre code. Sauvegardez également les paramètres utilisés dans un fichier de configuration pour tracer l’historique de vos expérimentations.

Documentez chaque étape dans un notebook Jupyter ou un script Python commenté. Cette habitude facilite la relecture et la compréhension du raisonnement, surtout si le projet doit être repris par une autre personne dans six mois.

Mesurer la performance de vos modèles avec des métriques pertinentes

Une fois le modèle entraîné, évaluez sa performance avec des métriques adaptées à votre problème métier. Pour la classification, l’accuracy mesure le pourcentage de prédictions correctes, mais cette métrique peut être trompeuse sur des données déséquilibrées. Si seulement 5% des clients souscrivent au produit, un modèle qui prédit toujours « non » atteint 95% d’accuracy sans aucune valeur prédictive.

Privilégiez le F1-score qui combine précision et rappel, ou l’AUC-ROC qui mesure la capacité du modèle à discriminer les classes indépendamment du seuil de décision. Pour la régression, le MSE (erreur quadratique moyenne) quantifie l’écart moyen entre prédictions et valeurs réelles.

| Métrique | Usage recommandé | Interprétation |

|---|---|---|

| Accuracy | Données équilibrées | % de bonnes prédictions |

| F1-score | Données déséquilibrées | Équilibre précision/rappel |

| AUC-ROC | Comparaison de modèles | Capacité de discrimination |

| MSE | Régression | Erreur quadratique moyenne |

Construisez un rapport de performance simple avec ces indicateurs et des graphiques de matrice de confusion. Présentez-le dans un format exploitable par vos interlocuteurs métier, en traduisant les scores en impact business : combien de clients correctement ciblés, quel gain financier potentiel.

Optimiser, comparer et industrialiser vos modèles psblearn

Au-delà du premier modèle fonctionnel, la valeur de psblearn se joue dans la capacité à optimiser, comparer et fiabiliser vos modèles. Cette partie aborde la recherche d’hyperparamètres, la validation croisée et les bonnes pratiques d’industrialisation légère. L’objectif est de vous mettre sur la voie de solutions robustes, reproductibles et maintenables.

Comment optimiser les hyperparamètres avec psblearn sans perdre le contrôle ?

Chaque algorithme possède des hyperparamètres qui influencent sa performance : profondeur maximale d’un arbre de décision, nombre de voisins dans un k-NN, régularisation dans une régression logistique. L’optimisation consiste à explorer différentes combinaisons pour trouver la configuration la plus performante.

psblearn propose des outils de grid search qui testent systématiquement toutes les combinaisons d’une grille de paramètres prédéfinie. Cette approche exhaustive garantit de ne pas manquer la meilleure configuration, mais devient coûteuse en temps de calcul sur de grandes grilles. Limitez le nombre de valeurs testées par paramètre, par exemple trois profondeurs d’arbre et trois valeurs de régularisation.

Le random search échantillonne aléatoirement dans l’espace des hyperparamètres. Cette méthode plus rapide donne souvent d’excellents résultats avec moins de calculs, surtout lorsque certains paramètres ont peu d’impact sur la performance finale.

Associez systématiquement la recherche d’hyperparamètres à une validation croisée. Divisez vos données d’entraînement en k plis (typiquement 5), entraînez le modèle sur k-1 plis et évaluez sur le pli restant. Répétez l’opération pour chaque pli et calculez la moyenne des scores. Cette technique offre une estimation plus robuste de la performance réelle avant mise en production.

Comparer plusieurs modèles psblearn pour choisir la meilleure approche

Face à un problème de prédiction, plusieurs algorithmes peuvent convenir : régression logistique, random forest, gradient boosting, SVM. La seule façon de départager ces approches est de les tester sur vos données réelles avec les mêmes métriques et le même protocole de validation.

Créez une boucle qui entraîne successivement chaque modèle sur le même ensemble d’entraînement et stocke les résultats dans un tableau comparatif. Calculez l’accuracy, le F1-score et le temps d’entraînement pour chaque algorithme. Cette comparaison objective vous permet de sélectionner le meilleur compromis entre performance et complexité.

| Modèle | F1-score | Temps entraînement (s) | Interprétabilité |

|---|---|---|---|

| Logistic Regression | 0.78 | 2 | Haute |

| Random Forest | 0.85 | 45 | Moyenne |

| Gradient Boosting | 0.87 | 120 | Faible |

Documentez les raisons de votre choix final. Si vous privilégiez le gradient boosting malgré son temps d’entraînement plus long, expliquez que le gain de performance justifie l’investissement. Cette traçabilité facilite les discussions avec les équipes métier et les décideurs qui doivent valider l’approche.

Intégrer psblearn dans un pipeline de production ou un projet existant

Un modèle entraîné n’a de valeur que s’il peut être réutilisé en production pour générer des prédictions sur de nouvelles données. psblearn permet de sérialiser vos modèles avec la bibliothèque pickle ou joblib. Sauvegardez le pipeline complet, transformations et modèle, dans un fichier unique.

Dans une API Flask ou FastAPI, chargez ce fichier au démarrage du service. Lorsqu’une requête arrive avec de nouvelles données, appliquez le pipeline pour obtenir une prédiction instantanée. Cette architecture simple convient pour des volumes de quelques centaines de requêtes par seconde sur un serveur standard.

Ajoutez des logs pour tracer chaque prédiction : horodatage, features en entrée, prédiction en sortie. Ces informations permettent de détecter les dérives de distribution des données dans le temps. Si la performance baisse en production, vous pourrez identifier si les données ont changé et décider d’un réentraînement du modèle.

Gérez les versions de vos modèles comme vous versionnez votre code. Utilisez un système de nommage explicite : modele_v1.2_20250315.pkl. Documentez les changements entre versions dans un fichier CHANGELOG pour faciliter le rollback en cas de problème après une mise à jour.

Bonnes pratiques, limites de psblearn et conseils pour aller plus loin

Même avec une API familière, chaque bibliothèque a ses forces, ses angles morts et ses subtilités d’usage. Cette dernière partie synthétise les bonnes pratiques, met en lumière les limites possibles de psblearn et propose des pistes d’approfondissement. Vous pourrez ainsi l’utiliser en pleine connaissance de cause, sans mauvaises surprises.

Quelles bonnes pratiques suivre pour utiliser psblearn de manière durable ?

La première règle consiste à versionner votre code avec Git dès le début du projet. Chaque expérimentation, chaque changement de paramètre doit être tracé dans un commit avec un message explicite. Cette discipline évite de perdre une configuration performante découverte trois semaines plus tôt.

Fixez les versions de vos dépendances dans un fichier requirements.txt. Spécifiez psblearn==1.2.3 plutôt que psblearn seul. Une mise à jour imprévue de la bibliothèque pourrait casser votre code en production si l’API change. Testez les montées de version dans un environnement de développement avant de les déployer.

Organisez vos projets avec une structure claire : dossier data/raw pour les données brutes non modifiées, data/processed pour les datasets transformés, models pour les fichiers sérialisés, notebooks pour l’exploration et src pour les scripts de production. Cette architecture facilite la navigation et la collaboration entre data scientists.

Créez des tests unitaires sur les fonctions critiques de prétraitement. Vérifiez par exemple que votre fonction d’encodage gère correctement une modalité inconnue en production. Un test rapide sur un échantillon de données détectera les régressions lors des futures modifications.

Limites actuelles de psblearn et complémentarités avec d’autres outils Python

psblearn montre ses limites face à des volumes de données dépassant la mémoire vive disponible. Sur des datasets de plusieurs centaines de gigaoctets, privilégiez des solutions distribuées comme Spark MLlib ou Dask-ML qui parallélisent les calculs sur plusieurs machines.

Pour le deep learning avec réseaux de neurones profonds, PyTorch et TensorFlow restent les références. psblearn ne propose pas nativement de couches convolutives, LSTM ou transformers. Si votre problème nécessite du traitement d’images ou de texte complexe, combinez psblearn pour le prétraitement et PyTorch pour la modélisation avancée.

Les applications temps réel avec latence inférieure à 10 millisecondes demandent des optimisations spécifiques que psblearn ne cible pas directement. Dans ces contextes, envisagez des frameworks C++ ou des modèles compilés avec ONNX pour réduire le temps d’inférence.

Envisagez psblearn comme une brique complémentaire. Vous pouvez l’utiliser pour l’exploration et le prototypage, puis basculer vers xgboost pour un gradient boosting très optimisé, ou vers LightGBM pour des données avec millions de lignes. L’écosystème Python encourage cette hybridation selon les contraintes de chaque étape du projet.

Où trouver des ressources, exemples et communauté autour de psblearn ?

La documentation officielle constitue le point de départ incontournable. Consultez le dépôt GitHub de psblearn pour accéder aux notebooks d’exemples qui illustrent les cas d’usage classiques : classification, régression, pipelines. Ces notebooks commentés accélèrent la prise en main en montrant du code fonctionnel.

La section FAQ du site répond aux questions récurrentes sur l’installation, les dépendances et les premières erreurs courantes. Si vous bloquez sur un problème spécifique, posez votre question sur Stack Overflow en taguant psblearn et scikit-learn. La communauté Python est active et réactive, surtout si vous fournissez un exemple minimal reproductible de votre problème.

Rejoignez les forums techniques et les groupes dédiés à la data science. Les retours d’expérience d’autres utilisateurs enrichissent votre pratique et vous alertent sur des pièges à éviter. Participez également en partageant vos propres solutions, cette contribution renforce l’écosystème collectif.

Commencez par des petits jeux de données publics comme ceux de Kaggle ou UCI Machine Learning Repository. Expérimentez sans pression sur des problèmes classiques : prédiction de prix immobiliers, classification d’iris, détection de fraude. Cette approche progressive vous permet d’apprivoiser psblearn tranquillement avant de l’appliquer sur vos données métier sensibles.

psblearn s’inscrit dans la continuité de scikit-learn en apportant des facilités pour la mise en production. En maîtrisant ses principes fondamentaux, en respectant les bonnes pratiques d’organisation et en connaissant ses limites, vous disposerez d’un outil fiable pour vos projets de machine learning au quotidien.